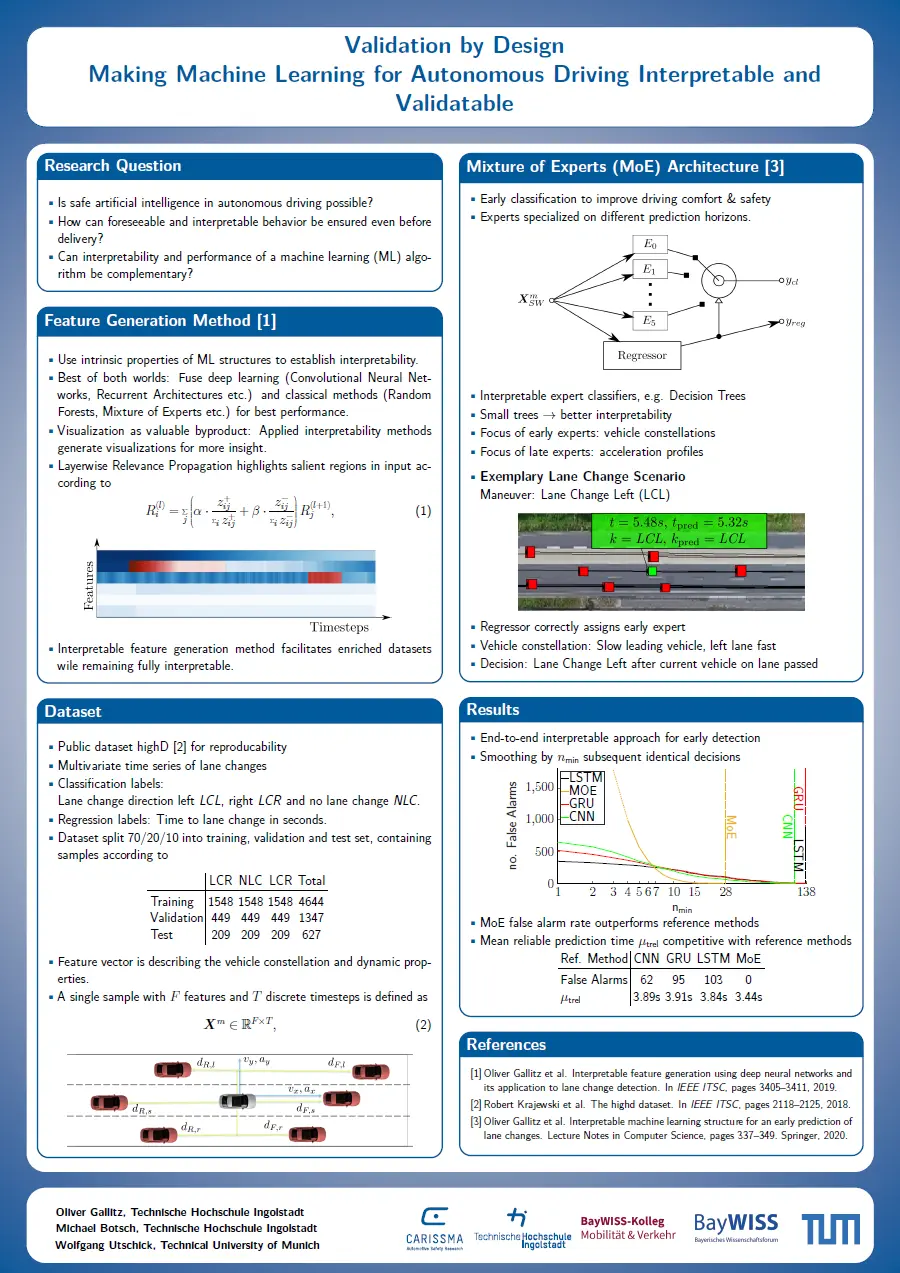

Das automatisierte Fahren geht mit einer drastisch zunehmenden Komplexität auf verschiedenen Ebenen einher. Dies beruht im Wesentlichen auf der Notwendigkeit, dass Fahrzeuge während des automatisierten Betriebs nicht nur den eigenen Zustand, sondern zusätzlich den Zustand unterschiedlicher, häufig unbekannter Objekte im Fahrzeugumfeld berechnen bzw. schätzen müssen. Um die dafür unvermeidlich hohe Komplexität auf algorithmischer Ebene zu adressieren, wird vermehrt maschinelles Lernen (ML) im Bereich der Wahrnehmung, der Situationsinterpretation und der Trajektorienplanung eingesetzt. Dies ist insbesondere den Vorzügen von ML-Methoden in der Verarbeitung sehr großer Datenmengen zu verdanken. ML-Methoden, wie etwa tiefe neuronale Netze, Ensemble Methoden oder verstärkendes Lernen werden häufig als Blackbox-Algorithmen angesehen, da die durch die Verfahren resultierenden mathematischen Abbildungen im Regelfall nicht auf physikalischen Modellen beruhen, sondern rein datenbasiert generiert werden. Dadurch ist eine Interpretation der Algorithmen nicht wie gewohnt möglich und eine Absicherung nach dem so genannten V-Modell der ISO 26262 aufgrund der nicht vollständigen Funktionsspezifikation nicht leicht durchführbar.

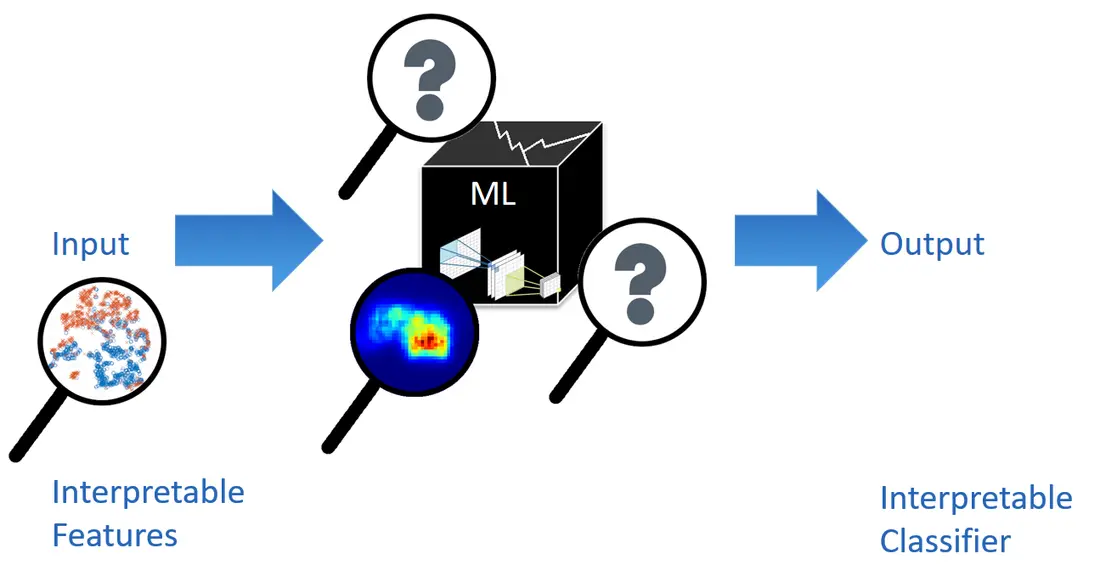

Häufig wird Interpretierbarkeit und Nachweisbarkeit durch Abstriche in der Modellkomplexität erkauft. In dem Projekt soll ein Ansatz für Freigabeprozesse von sicherheitskritischen Funktionen geschaffen werden, welche auch komplexe Algorithmen des maschinellen Lernens beinhalten können. Beispielsweise kann ML zur Identifikation relevanter interpretierbarer Merkmale eingesetzt werden, um eine validierbare Klassifikation zu ermöglichen.